Devenez Big Data Architecte & Machine Learning

24 jours

100% finançable

Formation RNCP

Jours de formation

Solutions de financement

Une formation pour qui ?

La formation Big data Architecture et Machine Learning s’adresse aux :

- Directeurs/Chefs de projet ou Responsable métier

- Responsable système d’informations

- Développeurs informatiques

- Consultants en business intelligence

- Ingénieurs d’étude, de recherche et développement, Architecte système et logiciel

- Consultants techniques, Consultants business

- Statisticiens et Mathématiciens

La formation Big Data Architecture et Machine Learning se distingue par la maîtrise de multi-compétences en Gestion de donnés massives.

Cette formation va vous permettre d’acquérir les compétences pour devenir Full Stack Big Data, à savoir : l’architecture et l’engineering Big Data, le stockage NoSQL, l’analyse et la science de données, la visualisation de données, le déploiement en Cloud d’une solution Big Data et l’administration d’une plateforme Big Data.

Maîtriser le concept Big Data pour la recherche, l’analyse, le partage et le stockage de données massives.

Explorer le potentiel BIG DATA au service de tous les métiers (Marketing, Contrôle de Gestion, Ressources humaines, Renseignement, Santé, Banque, Assurance…)

Pré-requis

- Avoir suivi la formation Développeur Java J2EE ou Microsoft.NET est un plus

- Avoir une expérience des bases de données relationnelles

- Posséder des connaissances approfondies en statistique est un plus

- Avoir des connaissances en Python

- Etre capable de travailler en équipe avec un sens d’écoute et d’analyse

A l’issue de la formation Big data Architecture et Machine Learning, le certifié sera en mesure de :

- Identifier les besoins et la problématique des directions métiers

- Maîtriser les technologies spécifiques au Big Data comme Hadoop, Pig, Hive, Spark, Yarn, Kafka, ELK, ou Cloudera

- Mettre en place un Data Lake

- Maîtriser les bases de données NoSQL : MongoDB, Cassandra, Neo4j, hBase, Redis…

- Maîtriser les technologies spécifiques à la science, à l’analyse ainsi qu’à la visualisation de données : Statistiques, Machine Learning, Deep Learning, langage R, Python, Tableau, PowerBI, R Shiny…

- Maîtriser le déploiement des solutions Big Data sur le Cloud : AWS, GCP, Microsoft Azure…

- Maîtriser la science de données et l’IA « Intelligence Artificielle » : Sprak Mlib, Scala, PySpark, RPA « Robotic Process Automation »

- Construire des modèles prédictifs pour répondre à la problématique

- Construire des algorithmes pour améliorer les résultats de recherche et de ciblage

- Trouver et rassembler l’ensemble des sources de données structurées ou non structurées nécessaires à l’analyse pertinente

- Identifier les opportunités à travers l’open data et les cas d’usage métiers

- Concevoir un projet Big Data (acquisition et stockage des données, traitement distribué, analyse de données à large échelle)

- Maîtriser les technologies par des études de cas concrètes

- Maîtriser les enjeux juridiques et liés à la protection des données

Programme détaillé

01- Big Data: Enjeux et perspectives

Voir le programme

Big Data : Introduction

- Introduction

- Types du big data

- Du SQL au NoSQL

- Caractéristiques techniques des 5V

- Technologies Big Data

- Languages Big Data

- Acteurs principaux du Big Data

- Différents métiers du Big Data

- Collecte et traitement des données structurées, semi-structurées et non-structurées

- Stockage des données

- Diffusion des données

- Traitements en temps réel ou différé: Kafka

- Architectures réparties : Hadoop

- Architecture Cloud / Scalabilité

- Impact de l’usage du Big Data

- Création de la valeur à partir des données

- Exemple d’architecture Big Data

Enjeux du Big Data

- Enjeux du big data en france

- ROI et Big Data

Marché Du Big Data

- Marché de la data au niveau mondial

- Évolutions et les acteurs de la chaine de l’offre Big Data

- Enjeux stratégiques (création de la valeur)

- Opportunités pour les entreprises de services informatiques

Impacts du Big Data sur l’entreprise

- Transformation de la relation client

- Transformation de l’organisation de l’entreprise

- Transformation du produit final

- Chaîne des valeurs, développement des nouvelles activités

- Productivité et optimisation des dépenses

- Apparition des nouveaux rôles/métiers (data scientists et CDO)

- Compétences nouvelles à acquérir

Solutions technologiques du Big Data

- L’écosystème de la plateforme Hadoop : Pig, Flume, Zookeeper, HBase, Oozie, YARN,

MapReduce… - Les modes de stockage (NoSQL, HDFS) / principes de fonctionnement de MapReduce

Méthodologie de gestion d’un projet Big Data

- Mise en place d’un projet Big Data

- Méthodologies recommandées pour lancer un projet Big Data

- Calcul du retour sur investissement d’un projet Big Data

Atelier pratique

02- Introduction à l’Architecture Big Data

Voir le programme

Introduction à l’architecture Big Data

- Définition du Big Data

- Comprendre le volume

- Besoin Big Data

- Introduction à l’architecture Big Data

- Distribution des données

- Rôles d’un projet Big Data

- Atelier pratique

Ecosystème Hadoop

- Technologies et Outils Big Data

- Découvrir l’écosystème Hadoop

- Les distributions Hadoop

- Atelier pratique

Mode de stockage HDFS et Base NoSql

- Comprendre HDFS

- HadoopFS

- Caractéristiques de HDFS

- Les modes de stockage HDFS

- Services HDFS

- Opération HDFS

- Administration d’un cluster HDFS

- Comprendre NoSQL

- Les modes de stockage NoSQL

- Choix du type de la Base de donnée NoSQL

- Atelier pratique

Principes du Traitement MapReduce

- Principes de fonctionnement de MapReduce

- Fonction map()

- Fonction reduce()

- Conception d’un MapReduce

- Atelier pratique

Architecture applicative

- Introduction

- Différentes étapes de gestion des données (Cycle de vie des données dans le Big Data)

- Définition du processus d’ingestion des données

- Outil disponibles sur le marché

- Modèle d’architecture applicative d’une solution Big Data

- Atelier pratique

Architecture technique

- Introduction à l’architecture technique

- Traitement de données

- Qualité des données (Data Quality)

- Architectures réparties (Clustering Hadoop)

- Atelier pratique

Modèles d’Architectures Big Data

- Introduction

- Architecture Datalake

- Architecture Lambda

- Architecture Kappa

- Architecture pour l’internet des objets (IoT)

- Atelier pratique

Critères de choix d’une architecture Big Data

- Introduction

- Critères de choix

- Le type de traitement

- L’utilisateur final des données

- La source des données (où les données sont générées)

- Format du contenu

- Types des données à traiter

- Fréquence et taille des données

- Méthodologie de traitement des données

- Le choix du matériel

- Récapitulatif des critères du choix d’une architecture big data

- Atelier pratique

03- NoSQL

Voir le programme

Introduction aux Bases de données NoSQL

- Histoire de NoSQL

- Comprendre le modèle NoSQL

- NoSQL Vs BDR

- Propriétés ACID

- Propriétés BASE

- Théorème de Brewer ou de CAP

- Caractéristiques NoSQL

Atelier pratique

Principaux modèles de BD NoSQL

- Familles des Bases de Données NoSQL

- Modèle NoSQL « Clé-Valeur »

- Modèle NoSQL orienté Colonne

- Modèle NoSQL orienté Document

- Modèle NoSQL orienté Graphe

- Bases de données NoSQL

- Comparatif des bases de données NoSQL

- Récapitulatif des types de schéma de données NoSQL

- HBase

- MongoDB

- Cassandra

- Redis

- Couchbase

- Elasticsearch

- Riak

Atelier pratique

Choix d’une Base de données NoSql

- Choisir une base de données NoSQL

- Classification des bases de données les plus utilisées

Atelier pratique

04- Hbase / Mongo DB

Voir le programme

Introduction à Hbase

- Définition de Hbase

- Hadoop vs Hbase

- Caractéristiques de Hbase

- Quand utiliser HBase

- Importance des bases de données NoSQL dans Hadoop

- Autres type de stockage NoSQL

- Comment HBase diffère des autres modèles NoSQL

- Quelle base de données NoSQL choisir?

- HBase Vs Hive

- HBase VS RDBMS

Atelier pratique

Architecture de Hbase

- Mécanisme de stockage dans HBase

- Stockage orienté colonne vs orienté ligne

- Modèle de données HBase

- Avantages de l’architecture Apache HBase

- Architecture HBase et ses composants importants

- Comment les composants Hbase fonctionnent ensemble

- Lecture et écriture dans HBase

- Récapitulatif des étapes d’écriture Hbase

- HBASE vs HDFS

- Cas d’utilisation de HBase

Atelier pratique

Installation de Hbase

- Modes d’installation d’Apache HBase

- Configuration de pré-installation

- Création d’un utilisateur Hadoop

- Configuration SSH et génération de clés

- Mise en place de Java

- Mise en place de Hadoop

- Installation de Hbase

- Comment télécharger la version stable du fichier tar Hbase

- Installation de HBase en mode autonome (Standalone)

- Installation de HBase en mode Pseudo distribué

- Installation de HBase en mode entierement distribué

- Dépannage de l’installation de HBase

Atelier pratique

Commandes générales Hbase SHELL

- La commande status

- La commande version

- La commande table_help

- La commande whoami

Atelier pratique

Manipulation des tables avec HBASE

- Commandes de gestion des tables

- Créer une table à l’aide de HBase Shell

- Créer une table à l’aide de l’API java

- Désactiver une table à l’aide de HBase Shell

- Désactiver une table à l’aide de l’API java

- Activation d’une table à l’aide de HBase Shell

- Activation d’une table à l’aide de l’API java

- Décrire et modifier une table à l’aide de Hbase Shell

- Décrire et modifier une table à l’aide de l’API java

- Existence d’une table à l’aide de HBase Shell

- Existence d’une table à l’aide de l’API java

- Suppression d’une table à l’aide de HBase Shell

- Suppression d’une table à l’aide de l’API java

- Fermer une table à l’aide de HBase Shell

- Fermer une table à l’aide de l’API java

Atelier pratique

Insérer et récupérer des données dans HBase: exemples get (), put (), scan ()

- Insertion ou écriture de données dans la table HBase: Shell

- Insertion de données à l’aide de l’API Java

- Mise à jour des données à l’aide de HBase Shell

- Mise à jour des données à l’aide de l’API Java

- Lecture de données à l’aide de HBase Shell

- Lecture de données à l’aide de l’API Java

- Suppression d’une cellule spécifique dans un tableau à l’aide de HBase Shell

- Suppression d’une cellule spécifique dans un tableau à l’aide de l’API Java

- Scanner à l’aide de HBase Shell

- compter et tronquer

- Sécurité

Atelier pratique

Avantages et limitations de Hbase

- Goulot d’étranglement des performances

- Avantages de HBase

- Limitations avec HBase

Introduction

- Stockage NoSQL

- Caractéristiques des bases NoSQL : CAP

- Choix d’une base de données NoSQL

- Bases de données orientées documents

- Historique et Présentation de MongoDB

- Cas d’utilisation de MongoDB

- Structure des données : notions de documents, de collections de valeurs

- Le format JSON

- Stockage de JSON

- JavaScript pour manipuler du JSON

Atelier pratique

Installation et configuration de MongoDB

- Plateformes supportées

- Installation de MongoDB sur Windows

- Choix de la version

- Téléchargement de MongoDB pour Windows

- Exécution

- Configuration

- Lancement de Mongo DB

- Connection à MongoDB

- Installation de MongoDB sur Linux

- Choix de la version

- Téléchargement de MongoDB pour Windows

- Exécution

- Configuration

- Lancement de Mongo DB

- Connection à MongoDB

Atelier pratique

Prise en main de MongoDb

- Utilisation de l’invite interactive

- Commandes de manipulation de base de données

- Utilisation d’un client graphique

- Importation d’une collection

- Manipulation du format BSON

- Comprendre le type ObjectId

Atelier pratique

Administration de MongoDB

- Sauvegarde des données

- Configuration de la journalisation

- Mise en place d’une réplication

- Configuration de la réplication

- Teste de la réplication

- Mise en place du sharding

- Configuration d’une collection pour le sharding

Atelier pratique

Manipulation des documents dans MongoDB

- Insérer un document

- Modifier et supprimer un document

- Utiliser une transaction

- Chercher des documents avec FIND()

- Comparer FIND() et SELECT en SQL

- Utiliser les opérateurs du FIND()

- Indexer pour améliorer les performances

Atelier pratique

MongoDB avancé

- Comprendre le framework d’agrégation

- Découvrir les étapes de l’agrégation

- Découvrir les opérateurs des Pipeline d’agrégation

Atelier pratique

05- Apache Hadoop

Voir le programme

Section 1: Introduction à l’écosystème Hadoop

- Aborder cette formation

- Découvrir NoSQL

- Définir le Big Data

- Comprendre l’histoire d’Hadoop

- Parcourir l’écosystème Hadoop

- Différencier les distributions Hadoop

- Comprendre le NoSQL

- Définition du Big Data

- Architecture de Hadoop

- L’Écosystème de Hadoop

- Rôle des différents composants de l’écosystème Hadoop

- Rôle des collecteurs de données

- Distributions d’Hadoop

Section 2: Installation de l’environnement Hadoop

- Installation de l’environnement Hadoop VM Ubuntu

- Installation de l’environnement Hadoop sur Windows

- Différencier les distributions Hadoop

- Découvrir Cloudera Hadoop

- Démarrer une QuickStart VM

- Travaux pratique: Installation Hadoop

Section 3: HDFS – La couche de stockage

- Comprendre le HDFS

- Découvrir HadoopFS

- Assimiler les principes du HDFS

- Appréhender les services HDFS

- Comprendre les opérations HDFS

- Configuration de HDFS

- Demarrage de HDFS

- Administrer le cluster HDFS

- Découvrir la gestion des services HDFS

- 0Manipuler les fichiers en ligne de commande

- Exécuter des opérations en Java

- Utiliser les InputStream Java

- Accéder à HDFS avec WebHDFS

- Caractéristiques de HDFS

- Architecture de HDFS

- Rôle de HDFS

- Opérations HDFS

- Listing des fichiers dans HDFS

- Insertion des données dans HDFS

- Extraction des données du HDFS

- Arrêt du HDFS

Section 4: Fonctionnement de MapReduce

- Appréhender les principes de base

- Découvrir la fonction map()

- Utiliser la fonction reduce()

- Concevoir un MapReduce

- Développer le mapper

- Développer le reducer

- Créer un jeu de données

- Créer le driver

- Lancer un MapReduce en Java

- Suivre l’évolution du MapReduce

- Développer un MapReduce en PHP

- Lancer des MapReduce avec Hadoop Streaming

- Principes de base de MapReduce

- Architecture MapReduce

- Fonction map()

- Fonction reduce()

- Conception d’un MapReduce

- Développer le mapper

- Développer le reducer

- Création d’un jeu de données

- Création d’un driver

- Lancer un MapReduce en Java

- Suivi de l’évolution du MapReduce

- Développement d’un MapReduce en PHP

- Lancement des MapReduce avec Hadoop Streaming

- TP : Fonctionnement de MapReduce

Section 5: Base de données NoSQL HBase

- Identifier les cas d’utilisation de HBase

- Comprendre le modèle Hbase

- Administrer HBase

- Appréhender les opérations HBase

- Gérer les services avec des interfaces web

- Lancer des commandes HBase dans le terminal

- Filtrer les résultats d’un scan

- Utiliser HBase en Java

- Utiliser HBase dans les MapReduce

- Définition de Hbase

- Hbase avec Hadoop

- Cas d’utilisation de HBase

- Comprendre le modèle Hbase

- Installation de Hbase

- Architecture

- Composants Hbase (Region, Region Server, Region Split)

- Lecture et écriture dans Hbase

- API Shell

- API Java

- TP : Base de données NoSQL HBase

Section 6: Apache Oozie -Ordonnanceur de WorkFlow

- Définition de Oozie

- Caractéristiques Oozie

- Fonctionnement de Oozie

- Actions Oozie

- Oozie Job

- Oozie workflow

- Coordinateur Oozie

- Paramètre Oozie

- Monitoring Oozie

- Packaging et déploiement d’une application de workflow Oozie

Section 7: Collecte de données avec Apache Sqoop

- Introduire scoop anglais

- Importer les données avec scoop

- Définition de Sqoop

- Cible des imports dans le cluster

- Architecture de Sqoop

- Fonctionnement de Sqoop

- Exemple d’import vers HDFS

- Exemples d’import vers Hive

- Exemple d‘exports

Section 8 : travaux pratiques: Développement d’une application Big Data avec Hadoop

- Mission 1: Conception de l’application

- Découper l’application

- Exploiter les données

- Concevoir la base de données HBase

- Parser le fichier d’entrée dans un mapper

- Écrire dans HBase avec un reducer

- Mettre en place des clés composites

- Utiliser les clés composites

- Lancer un modèle MapReduce d’import

Mission 2: Développement des modèles MapReduce

- Lire les données de HBase dans un mapper

- Agréger les données dans un reducer

- Suivre les modèles MapReduce

- Déboguer les modèles MapReduce

- Explorer les sources d’Hadoop

- Réaliser des jointures de données

- Résoudre le problème du secondary sort

- Optimiser ses modèles MapReduce

Mission 3: Développement des modèles MapReduce

- Mettre en place un workflow Oozie

- Lancer un workflow Oozie

- Filtrer les données de HBase

- Exporter dans MySQL grâce à Sqoop

- Lancer son workflow avec l’API HTTP REST

- Coupler l’application avec une interface web

06- Apache Spark

Voir le programme

Introduction à Apache Spark

- Apache Spark

- MapReduce VS Spark

- Caractéristiques d’Apache Spark

- Architecture d’Apache Spark

- Anatomie d’une application Spark

- Interaction avec Spark

- Spark sur Hadoop

- Composants de Spark

Atelier pratique

Installation de Spark

- Préparation d’une VM Linux

- Télécharger Apache Spark

- Installation d’Apache Spark : redhat /CentOS

- Installation d’Apache Spark : Windows

- Installation d’Apache Spark : Mac OS

- Installation d’Apache Spark : Ubuntu /Debian

Atelier pratique : Installation Spark

Resilient Distributed Datasets ( RDDs )

- Introduction aux RDDs (Resilient Distributed Datasets)

- Exemple d’un RDD

- Caractéristiques des RDDs

- Liaison avec Spark (Scala/Java/Python)

- Création d’un RDD

- Opérations RDD

- Actions RDD

- Transformation RDD

Atelier pratique

Spark streaming

- Définition

- Exemple Scala, Java et Python

- Concepts de base

- Initialisation de StreamingContext

- Flux discrétisés (DStreams)

Atelier pratique

Spark SQL

- Caractéristiques de Spark SQL

- Architecture Spark SQL

- Appréhender les abstractions de données de Spark

- Exploiter la Spark Session

- Créer un Data Frame

- Manipuler le DataFrame

- Comprendre les formats de stockage

- Construire un jeu de données

- Importer un fichier Avro

- Joindre des DataFrames

- Sauvegarder au format Parquet

- Employer la syntaxe select

- Utiliser un Dataset

- Exécuter un programme avec spark-submit

- Choisir une distribution Spark

- Conclure sur Apache Spark

Atelier pratique

07- Apache Kafka

Voir le programme

Introduction à Apache kafka

- Présentation de Kafka

- Intérêt d’Apache Kafka

- Les API de Kafka

- Terminologies de Kafka

- Atelier pratique

Architecture d’Apache kafka

- Architecture du cluster Kafka

- Topic

- Broker

- Zookeeper

- Producers

- Consumers

- Kafka WORKFLOW

Installation et configuration de Apache Kafka

- Installation et configuration d’Apache Kafka

- Installation de Java

- Installation de Zookeeper

- Installation de Kafka

- Atelier pratique: Installation

Commande Line Interface (CLI)

- Démarrez le serveur Kafka

- Lister tous les sujets

- Créer un topic

- Décrire un topic

- Publier des messages sur un topic

- Consommer des messages

- Modifier les sujets d’Apache Kafka

- Atelier pratique: CLI

Développement Kafka avec Java

- Introduction à la programmation Kafka

- Kafka APIs

- Création d’un projet Kafka

- Java producer

- Rappels des producers Java

- Producer Java avec clés

- Java consumer

- Consumer Java au sein d’un groupe de consumers

- Consumer Java avec threads

- Le consumer Java recherche et attribue

- Compatibilité de client bidirectionnelle

- Atelier pratique: Développement Kafka

Kafka Stream

- Introduction à Kafka Stream

- Concepts de Kafka Stream

- Architecture de Kafka Stream

- Démo: Application wordcount avec kafka stream

- Atelier pratique: KStream

08- Elastic Stack ELK

Voir le programme

Introduction à la suite ELK (ELK Stack)

- Aperçu sur la suite ELK

- Autres outils en relation avec ELK

- Rôle de Elastic Stack

- Installation de la suite ELK

- Installation de la suite ELK sur Windows

- Installation de la suite ELK sur Docker

Eléments du Stack ELK

- Elasticsearch: Le noyau

- Kibana: L’outil utilisateur

- Logstash: L’outil d’ingestion

- Beats: Transfert de données

- X-Pack: Le pack de fonctionnalités

Cas d’utilisation la suite ELK

- Gestion des logs

- Aperçu sur la gestion des logs

- Analyse des métriques

- Aperçu sur l’analyse des métriques

- Recherche de Sites et d’applications

- Analyse de sécurité

- Aperçu sur l’analyse de sécurité

- Monitoring des performances des applications

Chargement des données

- Données de chargement en masse

- Chargement d’échantillons de données

- Définition des types de données

Interrogation des données

- Requêtes simples

- Requêtes au niveau du terme

- Analyse et tokenisation

Analyse des données

- Agrégations de base

- Filtrer les agrégations

- Percentiles et histogrammes

Présentation de vos Insights

- Présentation et configuration de Kibana

- Création de visualisations dans Kibana

- Création de tableaux de bord dans Kibana

Dépannage du Stack

- Quand les choses vont mal

- Dépannage des ressources

Atelier cas pratique

- Installation et configuration (Serveur ElasticSearch, Mettre en place un cluster , Les rôles des

noeuds)

09- Gouvernance et Sécurité

Voir le programme

Introduction à la Gouvernance des données

- Rôle des données au 21e siècle

- Définition et principes de base de la gouvernance des données

- Gouvernance des données Vs Gestion des données

- Avantages de la gouvernance des données

- Gouvernance des données dans le cloud

- Outils de gouvernance des données

- Les étapes de la gouvernance des données

Atelier pratique

Déploiement de la gouvernance des données

- À qui appartiennent les données et pourquoi est-ce important?

- Rôles dans le domaine de la gouvernance des données

- Conception du processus de gouvernance des données

Atelier pratique

Gestion d’un programme de gouvernance des données

- Gestion et maintien de la gouvernance des données

- Suivi et mesure de votre programme

Atelier pratique

10- Mise en place d’un Data Lake

Voir le programme

Introduction aux données d’entreprise

- Données d’entreprise

- Importance de la qualité de la donnée

- Données du Big data

- Architectures Big Data

Atelier pratique

Introduction aux Data lake

- Présentation du Data lake

- Pertinence du Data lake dans une entreprise

- Avantage du Data lake

- Fonctionnement d’un Data Lake

- Différence entre le Data Lake et de Data Warehouse

- Défis du du Data lake

- Approches pour créer un Data Lake

- Conclusion

Atelier pratique

Architecture du Data Lake

- Architecture du Data lake

- Concepts clés du Data Lake

- Étapes de maturité du Data Lake

- Meilleures pratiques de l’architecture Data Lake

Atelier pratique

L’architecture Lambda basée sur Data Lake

- Introduction

- Couche d’ingestion de données

- Speed layer – traitement des données en temps quasi réel

- Couche de stockage de données – stocker toutes les données

- Serving layer – livraison et exportation de données

- Acquisition layer – Couche d’acquisition de données

- Messaging Layer – Couche de livraison de données

- Ingestion layer – Couche d’ingestion de données

- Exploration de la couche Lambda

- Magasins de données relationnelles

Atelier pratique

Écosystème Hadoop pour la mise en œuvre d’un Data lake

- Introduction

- Distributions Hadoop

- Facteurs de sélection d’un stack Big Data pour les entreprises

- Écosystème Hadoop pour un Data lake

Acquisition de données de données par lots avec Apache Sqoop

- Introduction

- Contexte dans Data Lake – Acquisition de données

- Fonctionnement de Sqoop

- Importation de données à l’aide de Sqoop

- Exportation de données à l’aide de Sqoop

- Connecteurs Sqoop

Atelier pratique

Acquisition de données de flux de données à l’aide d’Apache Flume

- Introduction

- Contexte dans Data Lake: acquisition de données

- Initiation à la Stream Data (Flux de données)

- Données Batch Vs données stream

- Acquisition de données de flux – cartographie technologique

- Fonctionnement de Flume

- Sqoop Vs Flume

Atelier pratique

Couche de messagerie utilisant Apache Kafka

- Introduction

- Contexte dans Data Lake – couche de messagerie

- Couche de messagerie

- Couche de messagerie – cartographie technologique

- Cycle de vie du flux de données

Atelier pratique

Traitement des données à l’aide d’Apache Flink

- Introduction

- Contexte dans un lac de données – couche d’ingestion de données

- Couche d’ingestion de données

- Data Ingestion Layer – cartographie technologique

- Fonctionnement de Flink

- Architecture Flink

Atelier pratique

Magasin de données à l’aide d’Apache Hadoop

- Introduction

- Contexte pour Data Lake – Stockage de données et lambda Batch Layer

- Stockage de données et Lambda Batch Layer

- Stockage de données et couche Lambda Batch – cartographie technologique

- Fonctionnement de Hadoop

- Architecture Hadoop

Atelier pratique

Magasin de données indexé à l’aide d’Elasticsearch

- Introduction

- Contexte dans Data Lake: stockage de données et lambda Speed layer

- Data Storage et Lambda Speed Layer

- Data Storage et Lambda Speed Layer: cartographie technologique

- Définition d’Elasticsearch

- Fonctionnement d’Elasticsearch

- Principes de l’architecture de base d’Elasticsearch

Atelier pratique

11- Python pour la data science

Voir le programme

Opérations basiques avec Python

- Python pour la data science

- Comprendre l’importance de la data science

- Expliquer le choix de Python

- Installation de Python

Opérations basiques avec Python

- Opérations basiques sur les listes

- Opérations avancées sur les listes

- Les dictionnaires

- Les compréhensions

Chargement et préparation des données

- Intérêt du prétraitement de données

- Chargement des fichiers Excel et CSV

- Chargement d’un fichier JSON

- Interrogation d’une base de données SQL Server

- Concaténation de différentes sources de données

- Fusion de différentes sources de données

- Manipulation des données manquantes

- Maîtrise des statistiques descriptives avec NumPy

- Maîtrise des statistiques descriptives avec Pandas

Manipulation des données

- Différents types de données

- Manipulation des données quantitatives avec NumPy

- Techniques d’encodage

- Manipulation des données textuelles avec Pandas

- Manipulation des données textuelles avec NLTK

- Utilisation des séries temporelles

- Manipulation des images

Atelier pratique Visualisation des donnée

Visualisation des données

- Découvrir les bases de la visualisation de données

- Matplotlib

- Seaborn

- Bokeh

- Aller plus loin avec Matplotlib

Initiation au Web scrapig

- Web scraping

- Exploration d’un document HTML avec Beautiful Soup

- Objets Tag et NavigableString

- Aller plus loin avec le web scraping

- Pratique du web scraping

Initiation aux algorithmes de machine learning

- Régression linéaire

- Mise en œuvre la régression linéaire

- Algorithme SVM

- Utilisation de l’algorithme SVM

- Classification naïve bayésienne

- Pratique de la classification naïve bayésienne

- Algorithme des k-moyennes

- Utilisation de l’algorithme des k-moyennes

- Analyse en composante principale PCA

Deep learning avec Keras et TensorFlow

- Définition du Deep learning

- Concepts du deep learning

- TensorFlow

- Keras

- Compréhension et préparation des données

- Déploiement du modèle

Atelier Pratique

12- Machine Learning

Voir le programme

Initiation au machine Learning

- Fondements du Machine Learning

- Introduction au Machine Learning

- Groupes de Machine Learning

- Besoins du Machine Learning

- Cycle de vie du Machine Learning

- Identification des biais cognitifs humains

Classification du machine Learning

- Théorie du Naïve Bayes

- Régression logistique binomiale

- Théorie k-NN

- Arbres de classification

- Forêts d’arbres de décision

- Support vector machine

Régression linéaire avec Python

- Définition de la régression

- Régression linéaire univariée

- Régression linéaire multivariée

- Régression linéaire polynomiale

- Régressions régularisées

- Programmer une régression linéaire en Python

- Utilisation des expressions lambda et des listes en intention

- Afficher la régression avec MathPlotLib

- L’erreur quadratique

- La variance

- Le risque

Initiation au clustering

- Définition du clustering

- Méthode k-means

- Clustering hiérarchique

Initiation aux Règles d’association

- Définition des règles d’association

- Initiation à la méthode A priori

- Évaluation des règles d’association candidates

Réduction dimensionnelle

- Définition de la réduction dimensionnelle

- Utilisation des méthodes de sélection de variables

- Méthode ACP

- Méthode ADL

Algorithmes Du Machine Learning

- Initiation à l’ensemble learning

- Apprentissage par renforcement

- Régression linéaire simple et multiple

- Régression polynomiale

- Séries temporelles

- Régression logistique et applications en scoring

- Classification hiérarchique et non hiérarchique (K-Means)

- Classification par arbres de décision ou approche Naïve Bayes

- Ramdom Forest (développement des arbres de décision)

- Gradiant Boosting

- Réseaux de neurones

- Machine à support de vecteurs

- Deep Learning : exemples et raisons du succès actuel

- Text Mining : analyse des corpus de données textuelles

Atelier cas pratique

Numpy Et Scipy

- Tableaux et matrices

- Algèbre linéaire avec Numpy

- Numpy et MathPlotLib

Scikit learn

- Machine Learning avec SKLearn

- Régression linéaire

- Création du modèle

- Echantillonnage

- Randomisation

- Apprentissage avec fit

- Prédiction du modèle

- Metrics

- Choix du modèle

- PreProcessing et Pipeline

- Régressions non polynomiales

Test et validation des algorithmes

- Validation des algorithmes

- Atelier cas pratique

- Techniques de ré-échantillonnage en jeu d’apprentissage, de validation et de test

- Mesures de performance des modèles prédictifs

- Matrice de confusion, de coût et la courbe ROC et AUC

Atelier cas pratique

Informations pratiques

Suivant le baromètre Besoin en Main d’Œuvre 2019 (BMO 2019) et la DARES, le nombre de postes à créer pour le consultant Big Data ainsi que les difficultés de recrutement en 2019 sont comme suit

Nombre de postes à pourvoir

National

Île-de-France

Auvergne-Rhône-Alpes

Occitanie

Quels sont les chiffres associés aux postes et à la formation ?

Salaire pour un junior en moyenne

Salaire pour un senior en moyenne

Recrutements jugés difficiles

%

National

%

Île-de-France

%

Auvergne-Rhône-Alpes

%

Occitanie

La formation « Big data Architecture et Machine Learning » va vous ouvrir un large panel de possibilités et vous permettre d’exercer les métiers suivants :

✔ Consultant Big Data

✔ Data Architect

✔ Data engineering

✔ Data Analyst

✔ Data Scientist avec Python

✔ Data Scientist avec R

✔ Data Scientist et Intelligence artificielle

✔ Architect cloud AWS, Azure ou GCP pour Big Data

✔ Développeur Full Stack Big Data

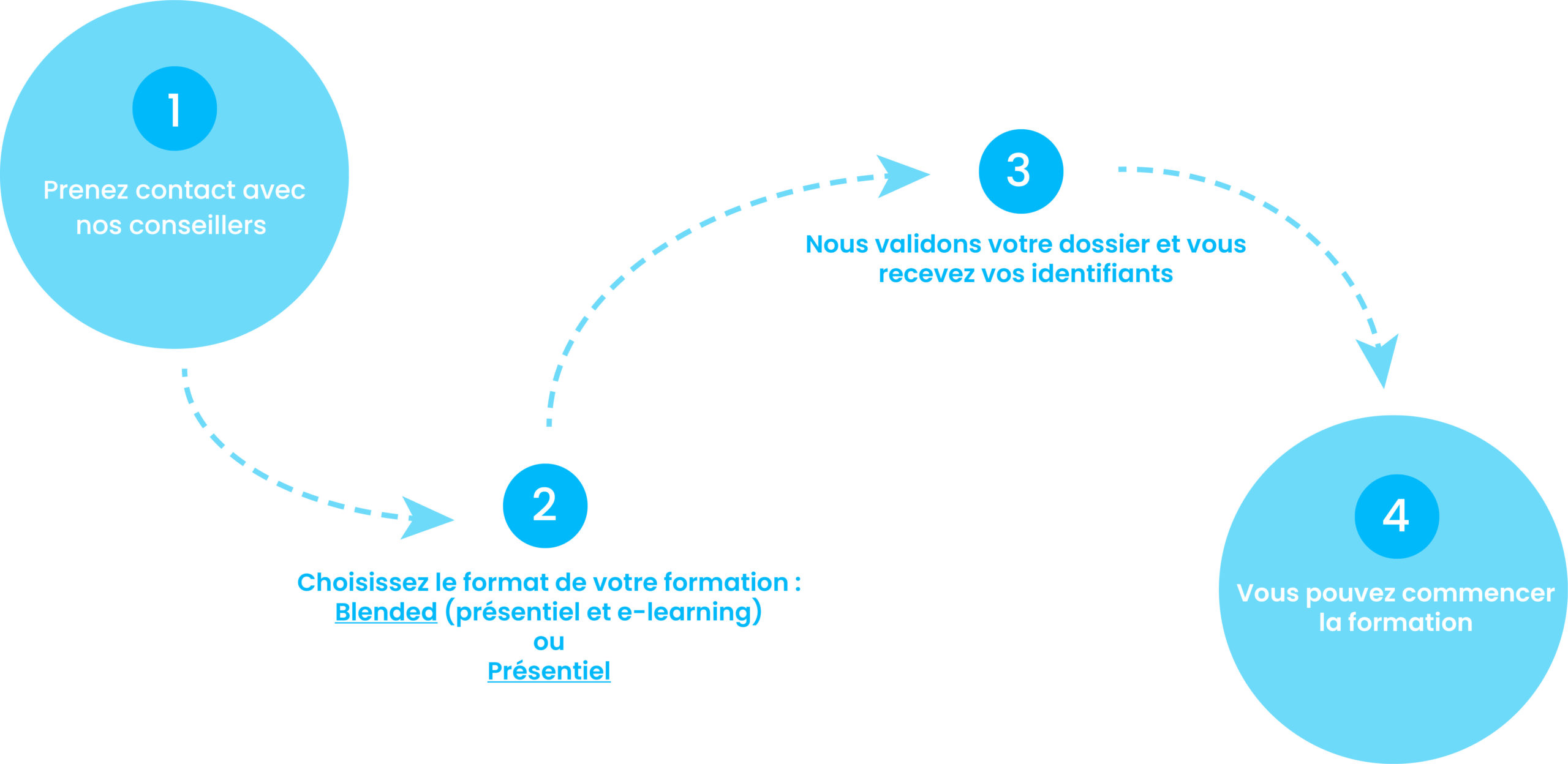

Comment suivre une formation chez nous ?

2. Choisissez le format de votre formation : Blended (présentiel et e-learning) ou présentiel

3. Nous validons votre dossier et vous recevez vos identifiants.

4. Vous pouvez commencer la formation.

Financez votre formation !

Financement CPF

CPF de transition

PDC

VAE

Contrat PRO

AFPR

AIF

POEc

POEi

Découvrez nos solutions

CPF de transition – CPF de transition pour une Reconversion Professionnelle

PDC- Plan de Développement de Compétences de l’entreprise.

VAE – Validation des Acquis de l’Expérience

Contrat PRO – Contrat d’alternance ou de Professionnalisation

AFPR – Action de Formation Préalable à l’Embauche

AIF – Aide Individuelle à la Formation par Pôle Emploi

POEc – Préparation Opérationnelle Emploi Collective

POEi – Préparation Opérationnelle Emploi Individuelle