Devenez Data analyst avec Python et R

16 jours

100% finançable

Formation RNCP

Jours de formation

Solutions de financement

Une formation pour qui ?

La formation Data scientist avec Python et R s’adresse aux :

- Directeurs/Chefs de projet ou Responsable métier

- Responsable système d’informations

- Développeurs informatiques

- Consultants en business intelligence

- Ingénieurs d’étude, de recherche et développement, Architecte système et logiciel

- Consultants techniques, Consultants business

- Statisticiens et Mathématiciens

Outre la maîtrise des enjeux et des perspectives, la formation Data Analyst avec Python et R se distingue par la maîtrise de multi-compétences en Gestion de donnés massives.

Cette formation va vous permettre d’acquérir les compétences suivantes : l’architecture et l’engineering Big Data, le stockage NoSQL, l’analyse et la science de données, la visualisation de données, le déploiement en Cloud d’une solution Big Data et l’administration d’une plateforme Big Data.

Maîtriser le concept Big Data pour la recherche, l’analyse, le partage et le stockage de données massives.

Explorer le potentiel BIG DATA au service de tous les métiers (Marketing, Contrôle de Gestion, Ressources humaines, Renseignement, Santé, Banque, Assurance…)

Pré-requis

- Avoir suivi la formation Développeur Java J2EE ou Microsoft.NET serait un plus

- Avoir une expérience des bases de données relationnelles

- Posséder des connaissances approfondies en statistique est un plus

- Etre capable de travailler en équipe avec un sens d’écoute et d’analyse

- Avoir des connaissances du langage R est un plus

A l’issue du module Data analyst avec Python et R, le certifié sera en mesure de :

- Identifier les besoins et la problématique des directions métiers

- Maîtriser les technologies spécifiques au Big Data comme Hadoop, Pig, Hive, Spark, Yarn, Kafka, ELK, ou Cloudera

- Mettre en place un Data Lake

- Maîtriser les bases de données NoSQL : MongoDB, Cassandra, Neo4j, hBase, Redis…

- Maîtriser les technologies spécifiques à la science, à l’analyse ainsi qu’à la visualisation de données : Statistiques, Machine Learning, Deep Learning, langage R, Python, Tableau, PowerBI, R Shiny…

- Maîtriser le déploiement des solutions Big Data sur le Cloud : AWS, GCP, Microsoft Azure…

- Maîtriser la science de données et l’IA « Intelligence Artificielle » : Sprak Mlib, Scala, PySpark, RPA « Robotic Process Automation »

- Construire des modèles prédictifs pour répondre à la problématique

- Construire des algorithmes pour améliorer les résultats de recherche et de ciblage

- Trouver et rassembler l’ensemble des sources de données structurées ou non structurées nécessaires à l’analyse pertinente

- Identifier les opportunités à travers l’open data et les cas d’usage métiers

- Concevoir un projet Big Data (acquisition et stockage des données, traitement distribué, analyse de données à large échelle)

- Maîtriser les technologies par des études de cas concrètes

- Maîtriser les enjeux juridiques et liés à la protection des données

Programme détaillé

Big Data: Enjeux et perspectives

Voir le programme

Big Data : Introduction

- Introduction

- Types du big data

- Du SQL au NoSQL

- Caractéristiques techniques des 5V

- Technologies Big Data

- Languages Big Data

- Acteurs principaux du Big Data

- Différents métiers du Big Data

- Collecte et traitement des données structurées, semi-structurées et non-structurées

- Stockage des données

- Diffusion des données

- Traitements en temps réel ou différé: Kafka

- Architectures réparties : Hadoop

- Architecture Cloud / Scalabilité

- Impact de l’usage du Big Data

- Création de la valeur à partir des données

- Exemple d’architecture Big Data

Enjeux du Big Data

- Enjeux du big data en france

- ROI et Big Data

Marché Du Big Data

- Marché de la data au niveau mondial

- Évolutions et les acteurs de la chaine de l’offre Big Data

- Enjeux stratégiques (création de la valeur)

- Opportunités pour les entreprises de services informatiques

Impacts du Big Data sur l’entreprise

- Transformation de la relation client

- Transformation de l’organisation de l’entreprise

- Transformation du produit final

- Chaîne des valeurs, développement des nouvelles activités

- Productivité et optimisation des dépenses

- Apparition des nouveaux rôles/métiers (data scientists et CDO)

- Compétences nouvelles à acquérir

Solutions technologiques du Big Data

- L’écosystème de la plateforme Hadoop : Pig, Flume, Zookeeper, HBase, Oozie, YARN,

MapReduce… - Les modes de stockage (NoSQL, HDFS) / principes de fonctionnement de MapReduce

Méthodologie de gestion d’un projet Big Data

- Mise en place d’un projet Big Data

- Méthodologies recommandées pour lancer un projet Big Data

- Calcul du retour sur investissement d’un projet Big Data

Atelier pratique

Introduction à l’Architecture Big Data

Voir le programme

Introduction à l’architecture Big Data

- Définition du Big Data

- Comprendre le volume

- Besoin Big Data

- Introduction à l’architecture Big Data

- Distribution des données

- Rôles d’un projet Big Data

- Atelier pratique

Ecosystème Hadoop

- Technologies et Outils Big Data

- Découvrir l’écosystème Hadoop

- Les distributions Hadoop

- Atelier pratique

Mode de stockage HDFS et Base NoSql

- Comprendre HDFS

- HadoopFS

- Caractéristiques de HDFS

- Les modes de stockage HDFS

- Services HDFS

- Opération HDFS

- Administration d’un cluster HDFS

- Comprendre NoSQL

- Les modes de stockage NoSQL

- Choix du type de la Base de donnée NoSQL

- Atelier pratique

Principes du Traitement MapReduce

- Principes de fonctionnement de MapReduce

- Fonction map()

- Fonction reduce()

- Conception d’un MapReduce

- Atelier pratique

Architecture applicative

- Introduction

- Différentes étapes de gestion des données (Cycle de vie des données dans le Big Data)

- Définition du processus d’ingestion des données

- Outil disponibles sur le marché

- Modèle d’architecture applicative d’une solution Big Data

- Atelier pratique

Architecture technique

- Introduction à l’architecture technique

- Traitement de données

- Qualité des données (Data Quality)

- Architectures réparties (Clustering Hadoop)

- Atelier pratique

Modèles d’Architectures Big Data

- Introduction

- Architecture Datalake

- Architecture Lambda

- Architecture Kappa

- Architecture pour l’internet des objets (IoT)

- Atelier pratique

Critères de choix d’une architecture Big Data

- Introduction

- Critères de choix

- Le type de traitement

- L’utilisateur final des données

- La source des données (où les données sont générées)

- Format du contenu

- Types des données à traiter

- Fréquence et taille des données

- Méthodologie de traitement des données

- Le choix du matériel

- Récapitulatif des critères du choix d’une architecture big data

- Atelier pratique

NoSQL

Voir le programme

Introduction aux Bases de données NoSQL

- Histoire de NoSQL

- Comprendre le modèle NoSQL

- NoSQL Vs BDR

- Propriétés ACID

- Propriétés BASE

- Théorème de Brewer ou de CAP

- Caractéristiques NoSQL

Atelier pratique

Principaux modèles de BD NoSQL

- Familles des Bases de Données NoSQL

- Modèle NoSQL « Clé-Valeur »

- Modèle NoSQL orienté Colonne

- Modèle NoSQL orienté Document

- Modèle NoSQL orienté Graphe

- Bases de données NoSQL

- Comparatif des bases de données NoSQL

- Récapitulatif des types de schéma de données NoSQL

- HBase

- MongoDB

- Cassandra

- Redis

- Couchbase

- Elasticsearch

- Riak

Atelier pratique

Choix d’une Base de données NoSql

- Choisir une base de données NoSQL

- Classification des bases de données les plus utilisées

Atelier pratique

Apache Hadoop

Voir le programme

Section 1: Introduction à l’écosystème Hadoop

- Aborder cette formation

- Découvrir NoSQL

- Définir le Big Data

- Comprendre l’histoire d’Hadoop

- Parcourir l’écosystème Hadoop

- Différencier les distributions Hadoop

- Comprendre le NoSQL

- Définition du Big Data

- Architecture de Hadoop

- L’Écosystème de Hadoop

- Rôle des différents composants de l’écosystème Hadoop

- Rôle des collecteurs de données

- Distributions d’Hadoop

Section 2: Installation de l’environnement Hadoop

- Installation de l’environnement Hadoop VM Ubuntu

- Installation de l’environnement Hadoop sur Windows

- Différencier les distributions Hadoop

- Découvrir Cloudera Hadoop

- Démarrer une QuickStart VM

- Travaux pratique: Installation Hadoop

Section 3: HDFS – La couche de stockage

- Comprendre le HDFS

- Découvrir HadoopFS

- Assimiler les principes du HDFS

- Appréhender les services HDFS

- Comprendre les opérations HDFS

- Configuration de HDFS

- Demarrage de HDFS

- Administrer le cluster HDFS

- Découvrir la gestion des services HDFS

- 0Manipuler les fichiers en ligne de commande

- Exécuter des opérations en Java

- Utiliser les InputStream Java

- Accéder à HDFS avec WebHDFS

- Caractéristiques de HDFS

- Architecture de HDFS

- Rôle de HDFS

- Opérations HDFS

- Listing des fichiers dans HDFS

- Insertion des données dans HDFS

- Extraction des données du HDFS

- Arrêt du HDFS

Section 4: Fonctionnement de MapReduce

- Appréhender les principes de base

- Découvrir la fonction map()

- Utiliser la fonction reduce()

- Concevoir un MapReduce

- Développer le mapper

- Développer le reducer

- Créer un jeu de données

- Créer le driver

- Lancer un MapReduce en Java

- Suivre l’évolution du MapReduce

- Développer un MapReduce en PHP

- Lancer des MapReduce avec Hadoop Streaming

- Principes de base de MapReduce

- Architecture MapReduce

- Fonction map()

- Fonction reduce()

- Conception d’un MapReduce

- Développer le mapper

- Développer le reducer

- Création d’un jeu de données

- Création d’un driver

- Lancer un MapReduce en Java

- Suivi de l’évolution du MapReduce

- Développement d’un MapReduce en PHP

- Lancement des MapReduce avec Hadoop Streaming

- TP : Fonctionnement de MapReduce

Section 5: Base de données NoSQL HBase

- Identifier les cas d’utilisation de HBase

- Comprendre le modèle Hbase

- Administrer HBase

- Appréhender les opérations HBase

- Gérer les services avec des interfaces web

- Lancer des commandes HBase dans le terminal

- Filtrer les résultats d’un scan

- Utiliser HBase en Java

- Utiliser HBase dans les MapReduce

- Définition de Hbase

- Hbase avec Hadoop

- Cas d’utilisation de HBase

- Comprendre le modèle Hbase

- Installation de Hbase

- Architecture

- Composants Hbase (Region, Region Server, Region Split)

- Lecture et écriture dans Hbase

- API Shell

- API Java

- TP : Base de données NoSQL HBase

Section 6: Apache Oozie -Ordonnanceur de WorkFlow

- Définition de Oozie

- Caractéristiques Oozie

- Fonctionnement de Oozie

- Actions Oozie

- Oozie Job

- Oozie workflow

- Coordinateur Oozie

- Paramètre Oozie

- Monitoring Oozie

- Packaging et déploiement d’une application de workflow Oozie

Section 7: Collecte de données avec Apache Sqoop

- Introduire scoop anglais

- Importer les données avec scoop

- Définition de Sqoop

- Cible des imports dans le cluster

- Architecture de Sqoop

- Fonctionnement de Sqoop

- Exemple d’import vers HDFS

- Exemples d’import vers Hive

- Exemple d‘exports

Section 8 : travaux pratiques: Développement d’une application Big Data avec Hadoop

- Mission 1: Conception de l’application

- Découper l’application

- Exploiter les données

- Concevoir la base de données HBase

- Parser le fichier d’entrée dans un mapper

- Écrire dans HBase avec un reducer

- Mettre en place des clés composites

- Utiliser les clés composites

- Lancer un modèle MapReduce d’import

Mission 2: Développement des modèles MapReduce

- Lire les données de HBase dans un mapper

- Agréger les données dans un reducer

- Suivre les modèles MapReduce

- Déboguer les modèles MapReduce

- Explorer les sources d’Hadoop

- Réaliser des jointures de données

- Résoudre le problème du secondary sort

- Optimiser ses modèles MapReduce

Mission 3: Développement des modèles MapReduce

- Mettre en place un workflow Oozie

- Lancer un workflow Oozie

- Filtrer les données de HBase

- Exporter dans MySQL grâce à Sqoop

- Lancer son workflow avec l’API HTTP REST

- Coupler l’application avec une interface web

Fondamentaux des statistiques

Voir le programme

Introduction aux statistiques

- Définition de la statistiques

- Enjeux des statistiques

- Histoire de la statistique

Démarches scientifique

- Méthode scientifique

- stratégie statistiques

- Pièges de la statistique

- Assimiler les normes statistiques ISO

- Démarche de l’analyse statistique

- Les biais cognitifs

Variables, indicateurs et les types de statistiques

- Les types de variables

- Les ratios à bon escient

- Les types de statistiques

- Les sous-familles de statistiques

- Les indicateurs statistiques

- La distribution statistique

Estimations et Tests

- L’estimation statistique

- Définition du but des tests

- Variantes d’un test statistique

- Importance des erreurs

- Importance de la p-value

- Intervalles statistiques

- L’échantillonnage

Atelier pratique

Analyse de données et méthodes statistiques

Voir le programme

Introduction à l’analyse de données

- Introduction sur l’analyse de données

- Métier de data analyst

- Rôle et les compétences d’un data analyst

Exploration de la données

- Identifier les données

- Comprendre les champs et types de données

- Retrouver des données

- Syntaxe

Préparation et interprétation des données

- Interpréter des données

- Retrouver des données

- Définir les jointures

- Comprendre les données et le flux de travail

- Découvrir les données nettoyées

Analyse des données avec un Tableau croisé dynamique

- Analyse bidimensionnelle: Découvrir les tableaux croisés dynamiques

- Aller plus loin avec les TCD

- Sélectionner et nommer les données

- Fractionner un texte

- Éliminer les doublons

Mener à bien un projet d’analyse de données

- Définition des bonnes pratiques

- Initiation à la gouvernance de données

- Erreurs fréquentes

- Création des modèles réutilisables

- Filtrage avec les jeux de données

Règles métiers et de documentation dans un projet d’analyse de données

- Définition des règles métiers

- Création d’un dictionnaire de données

- Création d’un fichier readme

Méthodes statistiques d’analyse de données

- Partie univariée (moyenne, écart type, variance, boite à moustache, histogramme)

- Partie multivariée (ACP,AFC,ACM)

Initiation au Machine Learning

- Régression linéaire

- Régression logistique

- Arbres de classification et de régression

- Méthode des k plus proches voisins(KNN)

- Partitionnement en K-moyennes (K-Mean Clustering)

Visualisation des données

- Créer les graphiques de base

- Insérer un graphique Excel

- Gérer les graphiques et les raccourcis par défaut

Atelier pratique

Statistiques avec R

Voir le programme

Aborder les statistiques paramétriques dans R

- Introduction au langage R

- Exploiter les fichiers source

- Étudier les statistiques descriptives

- Aller plus loin dans les statistiques descriptives

- Connaître le kurtosis et le skewness

- Générer et représenter une variable aléatoire

- Réviser les variables aléatoires scolaires

- Mettre des données sous forme de table de fréquence

- Mettre des données sous forme de table de contingence

- Calculer la matrice de corrélation et de covariance

Effectuer les tests d’adéquation et d’ajustement

- Faire le test d’ajustement du khi-deux

- Tester l’ajustement d’une loi de Poisson par le khi-deux

- Réaliser un test de normalité à un échantillon de Kolmogorov-Smirnov

- Réaliser un test de normalité de Ryan-Joiner

- Faire un test de normalité d’Anderson-Darling

Effectuer des tests de position

- Calculer la taille d’échantillon d’un test Z

- Calculer la puissance d’un test

- Vérifier l’intervalle de confiance de la moyenne d’un test Z

- Calculer la taille d’un échantillon de test t de Student

- Vérifier la puissance d’un test t de Student

- Étudier la résolution d’un test t de Student

- Vérifier l’intervalle de confiance de la moyenne d’un test t de Student

- Produire un test t de Student homoscédastique ou hétéroscédastique

- Faire un test t de Student hétéroscédastique

- Faire le test de Poisson sur un échantillon

- Appliquer le test de Poisson sur deux échantillons

Atelier pratique

Réaliser les tests de proportion

- Calculer la taille d’un échantillon de test p

- Créer un intervalle de confiance d’une proportion

- Comparer les proportions sur une même population

- Comparer les proportions sur deux échantillons indépendants

Produire des tests de dispersion

- Faire un test de Fisher d’égalité de deux variances

- Réaliser le test de Levene d’égalité de deux variances

- Créer un test de Bartlett d’égalité de variances

Tester et mesurer dans des tableaux croisés

- Réaliser un test d’indépendance du khi-deux d’une table de contingence

- Appliquer le test exact de Fisher

- Faire une mesure d’association V de Cramér

- Réaliser le test de Mantel-Haenszel-Cochran

Tests de valeurs aberrantes

- Test de Grubbs

- Test de Dixon

Transformations de données non normales

- Transformation de Box-Cox

- Transformations de Johnson

Atelier pratique

Visualisation de données avec Power BI / R-Shiny

Voir le programme

Introduction à Power BI

- Présentation De Power BI

- Caractéristiques de Power Bi

- Composants de Power BI

- Cycle de travail dans Power BI Desktop

- Configuration des options de Power BI

Création de requêtes basées sur Excel

- Importer un fichier Excel composé d’une feuille

- Importer un fichier Excel composé de plusieurs feuilles

- Importer un TCD Excel

- Atelier pratique : Création de requêtes basées sur Excel

Préparation des données

- Choix des colonnes

- Nettoyage des données

- Conversion des données

- Transformation des données

- Ajout des colonnes selon 2 méthodes

- Fusion des requêtes

- Combinaison des requêtes

- Atelier pratique : Préparation des données

Création de requêtes sur une base de données

- Appréhender l’import et la requête directe

- Importer les tables

- Atelier pratique : Création de requêtes sur une base de données

Création de requêtes sur d’autres sources

- Importer plusieurs fichiers Excel

- Créer une requête sur un fichier TXT ou CSV

- Effectuer une requête à partir du web

- Requêter à partir d’un fichier PDF

- Atelier pratique : Création de requêtes sur d’autres sources

Organisation des tables et des relations

- Utiliser la vue Modèle

- Mettre en place les relations

- Connaître les bonnes pratiques d’organisation des tables

- Formater et organiser les données

- Créer une mesure

- Atelier pratique : Organisation des tables et des relations

Création de la table de temps

- Nécessité d’une table de temps

- Créer la table à l’aide d’un script DAX

- Associer la table au modèle et ajuster les champs

- Déterminer le nombre de tables du temps

- Atelier pratique : Création de la table de temps

Mise en place des principaux graphiques et tableaux

- Aborder les règles d’ergonomie et de composition d’un rapport

- Découvrir l’interface de Power BI

- Choisir judicieusement les couleurs

- Créer et configurer un histogramme

- Créer et configurer un graphique en courbe

- Créer un graphique en secteur

- Créer une carte

- Créer une carte à plusieurs lignes

- Ajouter une zone de texte et une image pour le titre

- Créer une carte géographique

- Atelier pratique : Mise en place des principaux graphiques et les tableaux

Filtrage des données

- Créer un segment

- Synchroniser les segments entre plusieurs pages

- Utiliser le volet Filtre

- Atelier pratique : Filtrage des données

Utilisation des tableaux

- Créer un tableau simple

- Créer un tableau croisé

- Dupliquer la mise en forme

- Atelier pratique : Utilisation des tableaux

Exportation des données

- Récupérer les données au format Excel/CSV et exporter au format PDF

- Introduction à Power BI Service

- Atelier pratique : Exportation des données

__________________

Introduction à R Shiny

- Définition de R-Shiny

- Les applications de données

- Créer des applications de données avec Shiny

- Exécuter des applications Shiny sur votre propre machine

- Quitter les applications Shiny sur votre ordinateur local

- Déployer des applications sur shinyapps.io

- Déployer des applications avec Shiny Server

Applications Shiny à fichier unique et fractionné

- Applications de fichier unique (single) avec shinyApp

- Applications de fichiers fractionnés (Split-file)

- Fichier ui.R

- Fichier server.R

Shiny Apps 101

- Créer une application Shiny simple à partir de zéro

- Comprendre input$var and output$plot

- Fonctions de rendu et de sortie

- Utilisation de l’argument session

- Ne jamais dupliquer les entrées ou sorties

Tableaux de données en Shiny

- Choisir une solution de table

- Tables statiques avec renderTable

- Tables statiques avec kableExtra

- Tables interactives avec DT

Obtenir des données dans vos applications Shiny

- Applications et données Shiny101

- Inclure des fichiers de données dans une application Shiny

- Shiny et les packages qui se connectent à l’API

- Shiny et les Fichiers .httr-oauth

- Variables d’environnement Shiny et R

Atelier cas pratique

Contrôles basés sur les données

- Remplir les menus déroulants à partir des données

- Choix d’étiquettes dans selectInput

- Contrôles interdépendants pour filtrer les données

- Contrôler les mises à jour des applications avec actionButton

Autoriser les utilisateurs à Uploader et télécharger des données

- Autoriser les utilisateurs à télécharger des données à partir d’une application

- Télécharger les données des tables DT

- Autoriser les utilisateurs à Uploader des données dans une application

- Utiliser rhandsontable pour collecter des données

Résolution de problèmes dans des applications Shiny

- Résolution de problèmes dans les applications Shiny 101

- Impression sur la console R dans les applications Shiny

- Débogage des applications avec shinyjs :: runcodeUI

- Utilisation de reactlog pour déboguer les applications Shiny

Rendre les applications Shiny ergonomique

- Application de CSS personnalisé aux applications Shiny

- Insertion des images dans des applications Shiny

- Affichage des fileurs (spinners) de chargement dans les applications Shiny

Déploiement des applications Shiny

- Où pouvez-vous déployer des applications Shiny?

- Connecter RStudio à shinyapps.io

- Gérer les applications Shiny avec rsconnect

- Déploiement d’applications par programme

Atelier cas pratique

Informations pratiques

Suivant le baromètre Besoin en Main d’Œuvre 2019 (BMO 2019) et la DARES, le nombre de postes à créer pour le consultant Big Data ainsi que les difficultés de recrutement en 2019 sont comme suit

Nombre de postes à pourvoir

National

Île-de-France

Auvergne-Rhône-Alpes

Occitanie

Quels sont les chiffres associés aux postes et à la formation ?

Salaire pour un junior en moyenne

Salaire pour un senior en moyenne

Recrutements jugés difficiles

%

National

%

Île-de-France

%

Auvergne-Rhône-Alpes

%

Occitanie

Le module « Data analyst avec Python et R » va vous ouvrir un large panel de possibilités et vous permettre d’exercer les métiers suivants :

✔ Consultant Big Data

✔ Data Architect

✔ Data engineering

✔ Data Analyst

✔ Data Scientist avec Python

✔ Data Scientist avec R

✔ Data Scientist et Intelligence artificielle

✔ Architect cloud AWS, Azure ou GCP pour Big Data

✔ Développeur Full Stack Big Data

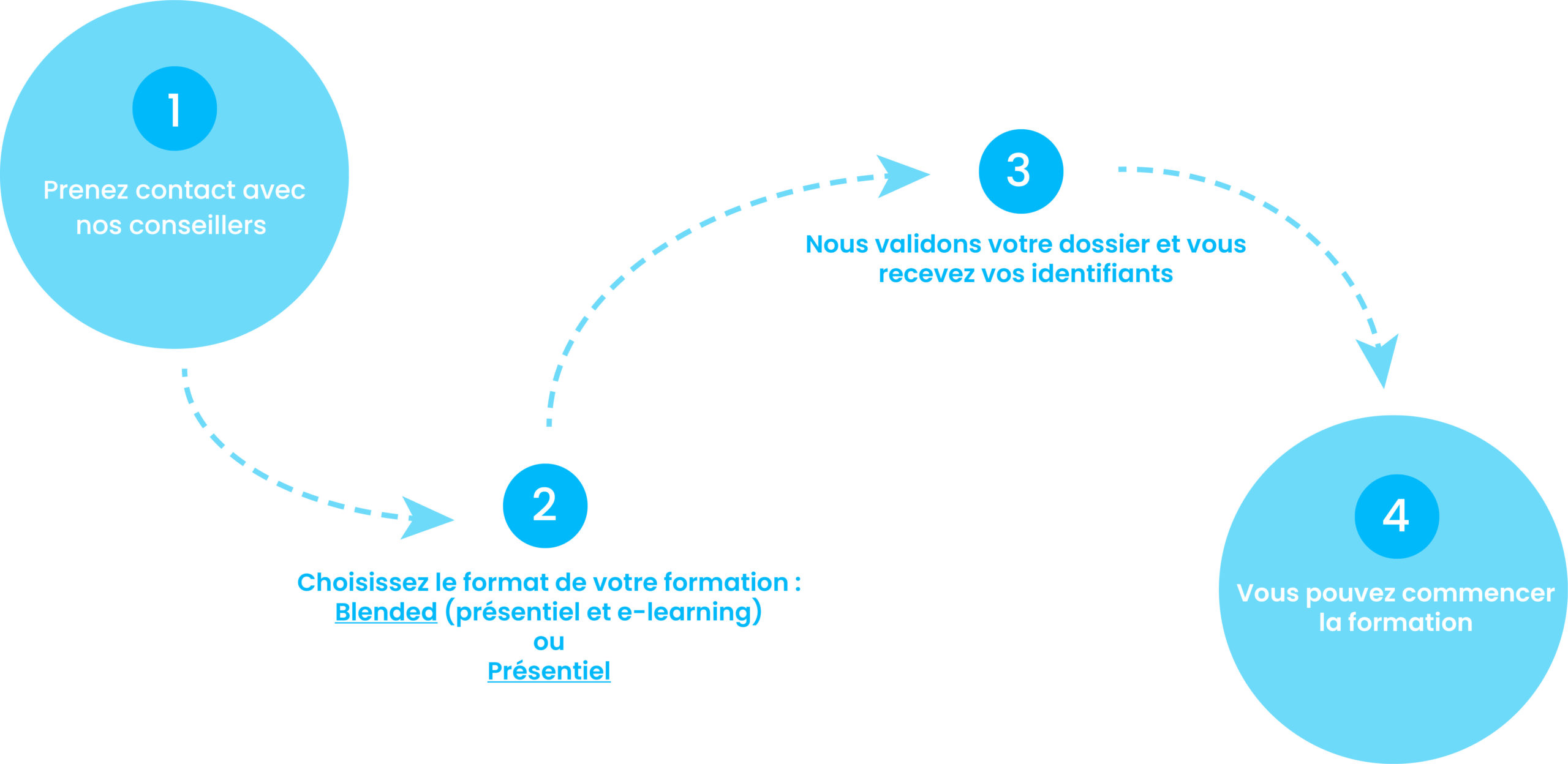

Comment suivre une formation chez nous ?

2. Choisissez le format de votre formation : Blended (présentiel et e-learning) ou présentiel

3. Nous validons votre dossier et vous recevez vos identifiants.

4. Vous pouvez commencer la formation.

Financez votre formation !

Financement CPF

CPF de transition

PDC

VAE

Contrat PRO

AFPR

AIF

POEc

POEi

Découvrez nos solutions

CPF de transition – CPF de transition pour une Reconversion Professionnelle

PDC- Plan de Développement de Compétences de l’entreprise.

VAE – Validation des Acquis de l’Expérience

Contrat PRO – Contrat d’alternance ou de Professionnalisation

AFPR – Action de Formation Préalable à l’Embauche

AIF – Aide Individuelle à la Formation par Pôle Emploi

POEc – Préparation Opérationnelle Emploi Collective

POEi – Préparation Opérationnelle Emploi Individuelle